Pix2Pixは、画像から画像への変換を可能にする生成AI技術で、機械学習の分野で注目を集めています。この記事では、Pix2Pixの基本的な仕組みから実装方法、応用例までを解説します。

Pix2Pixとは

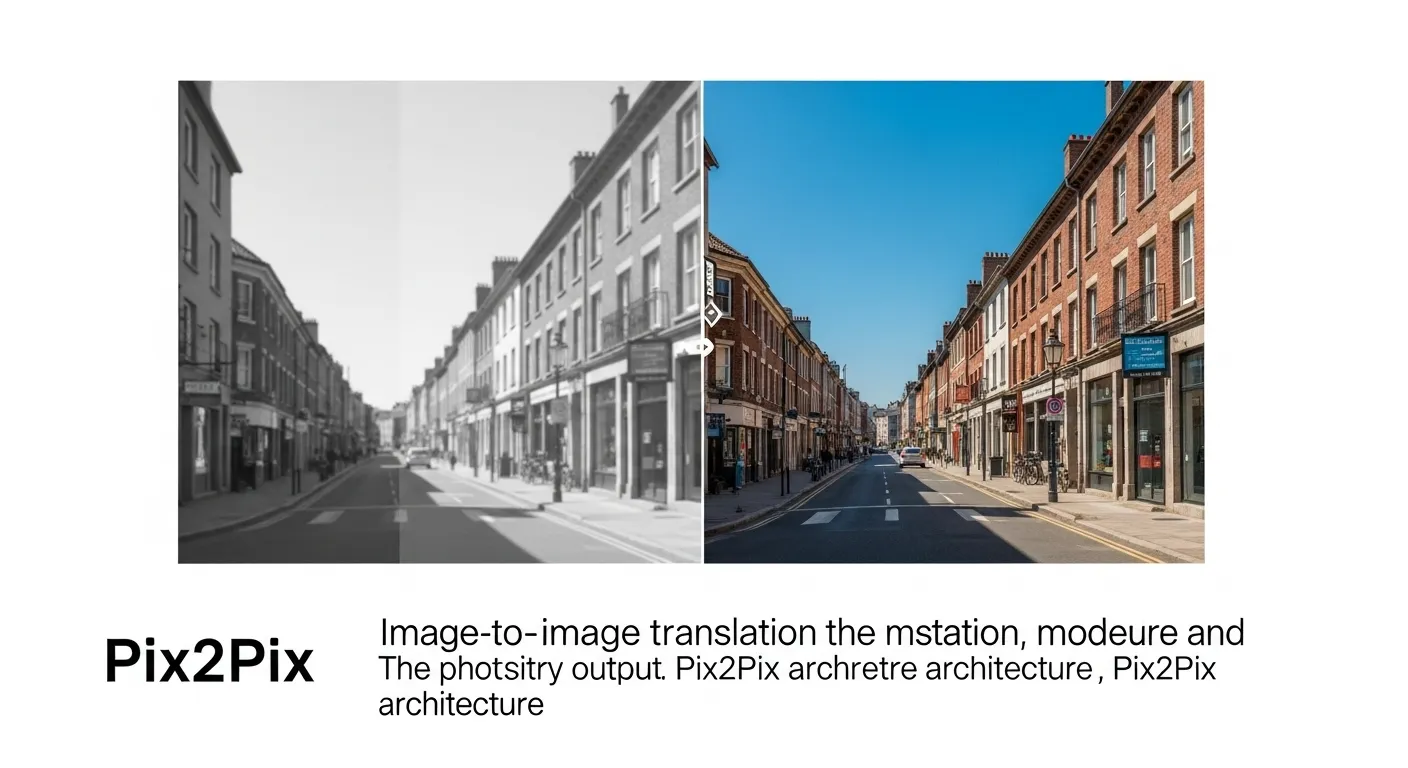

Pix2Pixは、画像を入力として別の画像に変換する技術であり、深層学習の一種である生成的アドバーサリアルネットワーク(GAN)を活用しています。

この技術は、例えば白黒写真をカラー化したり、スケッチをリアルな画像に変換したりする際に役立ちます。以下では、Pix2Pixの基本的な仕組みや特徴について詳しく見ていきます。

Pix2Pixで実現できる画像生成の可能性

Pix2Pixは、画像生成の分野で幅広い応用が可能です。具体的には、以下のようなシーンで活用されています。

- 白黒写真のカラー化

- スケッチからリアルな画像生成

- セマンティックマップから写真のような画像生成

- 医療画像の変換(例:MRIからCT画像へ)

これらの応用例から、Pix2Pixはクリエイティブな分野だけでなく、医療や工学など専門的な領域でも価値を発揮します。実際に、デザイナーやエンジニアがこの技術を使って効率的に作業を進めている事例も増えています。

Pix2Pixと他の生成AI技術の比較

Pix2Pixを理解する上で、他の生成AI技術との違いを把握することが必要です。特に、CycleGANとの比較がよく話題に上がります。以下は、Pix2PixとCycleGANの主な違いをまとめた比較表です。

| Pix2Pix | CycleGAN | |

|---|---|---|

| 学習データ | ペアデータが必要 | 非ペアデータで学習可能 |

| 応用例 | スケッチ→写真、セマンティックマップ→画像 | スタイル変換(例:馬→シマウマ) |

| モデルの構造 | U-Net+GAN | 双方向のGAN |

| 計算コスト | 比較的低い | 高い |

この表から、Pix2Pixは入力と出力の対応が明確なデータが必要な点で、CycleGANとは異なるアプローチを取ることがわかります。ペアデータを使うことで、Pix2Pixはより正確な変換を実現しますが、データ準備の手間がかかる場合もあります。

Pix2Pixの仕組みと技術的背景

Pix2Pixの核となる技術は、GAN(Generative Adversarial Network)とU-Netアーキテクチャの組み合わせです。このセクションでは、Pix2Pixの仕組みを技術的な視点から掘り下げ、解説します。

Pix2Pixのデータセット準備のポイント

Pix2Pixを効果的に活用するには、適切なデータセットの準備が欠かせません。以下は、データセット作成時の注意点です。

- ペアデータの収集:入力画像と対応する出力画像のペアを用意する

- データ量:数千~数万のペアデータを用意することが理想

- データ品質:ノイズの少ない、クリアな画像を使用する

- 正規化:画像サイズや色空間を統一する

データセットの質と量が、生成される画像の精度に直結します。例えば、スケッチから写真を生成する場合、スケッチと写真のスタイルが一致しているペアデータを用意することで、モデルがより正確な変換を学習できます。データ準備は手間がかかりますが、Pix2Pixの性能を最大限に引き出すためにはこのプロセスが不可欠です。

Pix2Pixの損失関数の役割

Pix2Pixの学習では、損失関数が重要な役割を果たします。損失関数は、生成された画像がどれだけ目標に近いかを評価する指標です。Pix2Pixでは以下の2つの損失関数を組み合わせています。

- GAN損失:生成画像が本物らしいかどうかを評価

- L1損失:生成画像と正解画像のピクセルレベルの差を評価

これらの損失関数を組み合わせることで、Pix2Pixはリアルで正確な画像生成を実現します。特に、L1損失を導入することで、生成画像が正解画像に近づくよう細かく調整されます。このバランスが、Pix2Pixの高い生成精度の秘訣です。

U-Netアーキテクチャの特徴

Pix2Pixのモデル構造の中心は、U-Netと呼ばれるアーキテクチャです。U-Netは、以下のような特徴を持ちます。

- エンコーダーとデコーダー:画像を圧縮し、再度展開する構造

- スキップ接続:低レベル特徴を保持し、詳細な画像生成を支援

- 軽量な設計:比較的少ない計算リソースで高精度を実現

U-Netのスキップ接続は、入力画像の細かい情報を保持しながら変換を行うため、生成画像の品質向上に大きく貢献します。この構造により、Pix2Pixは複雑な画像変換タスクでも安定した結果を出力できます。

Pix2Pixの実装と使い方

Pix2Pixを実際に使ってみたいという方のために、実装方法や具体的な使い方を解説します。プログラミングの知識がある程度必要ですが、初心者でも理解できるようにステップごとに説明します。

Pix2Pixの実装手順

Pix2Pixを実装するには、Pythonと深層学習フレームワーク(TensorFlowやPyTorch)を使用します。以下は基本的な実装手順です。

- 環境構築:TensorFlowまたはPyTorchをインストール

- データセット準備:ペアデータを用意し、適切な形式に変換

- モデル構築:U-NetとGANを組み合わせたモデルを定義

- 学習実行:データセットを使ってモデルをトレーニング

- 推論:学習済みモデルで新しい画像を生成

実装には、GitHub上で公開されているPix2Pixの公式リポジトリが参考になります。リポジトリにはサンプルコードやデータセット例が含まれているため、初心者でも試しやすい環境が整っています。実際に手を動かしてみることで、Pix2Pixの仕組みをより深く理解できます。

Pix2Pixを活用した実例

Pix2Pixは、以下のような実例で活用されています。

- アート制作:スケッチをリアルな絵画に変換

- ゲーム開発:低解像度画像を高解像度に変換

- 建築デザイン:平面図から3Dレンダリングを生成

これらの事例から、Pix2Pixはクリエイティブな作業を効率化するツールとして広く利用されています。特に、デザイナーがアイデアを素早くビジュアル化する際に役立つことが多く、プロトタイピングの時間を大幅に短縮できます。

Pix2PixとCycleGANの違いを深掘り

Pix2PixとCycleGANは、どちらも画像変換に使われる技術ですが、目的やアプローチが異なります。このセクションでは、両者の違いをさらに詳しく比較し、どの技術を選ぶべきかを明確にします。

データセットの違いとその影響

Pix2Pixはペアデータが必要ですが、CycleGANは非ペアデータで学習可能です。この違いは以下のような影響を与えます。

- Pix2Pix:正確な変換が必要な場合に適している(例:スケッチ→写真)

- CycleGAN:データ収集が難しい場合やスタイル変換に適している(例:夏の風景→冬の風景)

ペアデータが必要なPix2Pixは、データ準備に時間がかかる一方で、変換の精度が高いというメリットがあります。一方、CycleGANはデータ準備が簡単ですが、変換結果の制御が難しい場合があります。用途に応じて適切な技術を選ぶとよいでしょう。

応用範囲と限界

Pix2Pixは、明確な入力と出力の関係を学習するため、以下のようなケースで優れています。

- セマンティックマップから写真生成

- 医療画像の変換

一方、CycleGANはスタイル変換に特化しており、以下のような用途に適しています。

- 絵画スタイルの変換(例:モネ風→ゴッホ風)

- 動物の種類変換(例:犬→猫)

両者の限界としては、Pix2Pixはデータセットの準備が大変、CycleGANは生成結果の予測が難しい点が挙げられます。プロジェクトの目的やリソースに応じて選択しましょう。

Pix2Pixの今後の可能性

Pix2Pixは、生成AI技術の進化とともにさらに発展が期待されています。例えば、以下のような進化が予想されます。

- データ効率の向上:少ないデータで高精度なモデルを構築

- リアルタイム処理:高速な画像変換の実現

- 多様な応用:新しい分野(例:VR/AR)での活用

これらの進化により、Pix2Pixはさらに幅広い分野で活用される可能性があります。特に、生成AIの民主化が進む中で、初心者でも簡単に使えるツールとしての発展が期待されます。

この記事では、Pix2Pixの基本から実装、応用例までを網羅的に解説しました。Pix2Pixは、画像生成AIのツールとして、クリエイティブな作業から専門的な分野まで幅広く役立ちます。ぜひこの記事を参考に、Pix2Pixを活用したプロジェクトを始めてみてください。

コメント